Будь осторожен с тем, что ты пишешь чат‑боту

В эпоху, когда ИИ‑чат‑боты стали частью повседневной жизни, всё чаще возникает ощущение, что это «личный» разговор. Можно задать любой вопрос, получить «понимающий» ответ, обсудить сложную ситуацию или попросить совета. Но важно помнить: чат‑бот – это не человек и не доверенное лицо. Это цифровой сервис со своими правилами хранения и использования данных.

Поводом задуматься об этом стала статья «Be Careful What You Tell Your AI Chatbot», опубликованная на сайте Stanford Human‑Centered Artificial Intelligence (HAI). В ней исследователи обращают внимание на риски, связанные с приватностью пользовательских данных при общении с ИИ.

О чём говорит исследование Стэнфорда

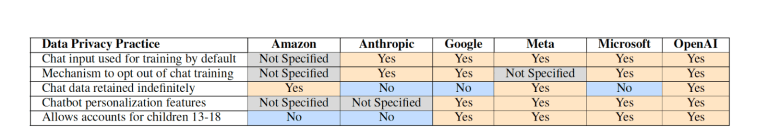

Учёные проанализировали политики конфиденциальности крупнейших разработчиков ИИ‑чат‑ботов. Выяснилось, что во многих случаях пользовательские диалоги:

- могут сохраняться на серверах компаний;

- используются для обучения и улучшения моделей;

- хранятся длительное время;

- обрабатываются на условиях, которые сложно понять без юридической подготовки.

Часто формально у пользователя есть возможность отказаться от использования его данных для обучения моделей, но эта опция либо скрыта, либо сформулирована неочевидно. В результате многие люди даже не подозревают, что их сообщения могут становиться частью обучающих датасетов.

Особое внимание в исследовании уделяется чувствительной информации: данным о здоровье, личной жизни, финансах и детям. Именно здесь риск неправильного использования или утечки информации наиболее высок.

Кто стоит за этой работой

Материал опубликован от имени Stanford HAI – междисциплинарного института Стэнфордского университета, который изучает не только развитие ИИ-технологий, но и их влияние на повседневную жизнь. Исследователей интересует, как такие системы используются на практике, какие риски они создают и какие последствия могут иметь для пользователей.

Stanford HAI объединяет специалистов из компьютерных наук, права, социальных наук и образования. Институт был создан именно потому, что технологии развиваются быстрее, чем общие правила и понимание того, как ими пользоваться безопасно и ответственно, особенно когда речь идёт о данных людей и приватных разговорах.

Одним из ключевых экспертов исследования стала Дженнифер Кинг – специалист по вопросам приватности и политики данных. Она много лет изучает пользовательские соглашения и реальные практики сбора информации и обращает внимание на важный разрыв: большинство людей не читает и не может разобраться в сложных правилах конфиденциальности, а значит, ответственность за ясность и честность должна лежать на разработчиках, а не на пользователях.

Почему люди рассказывают чат-ботам больше, чем собирались

Исследование Стэнфорда фиксирует, что пользователи делятся с ИИ личной и чувствительной информацией. При этом такое поведение не является случайным – у него есть вполне объяснимые причины.

Во-первых, чат-бот воспринимается как нейтральный собеседник. Он не перебивает, не осуждает, не спорит и не удивляется. Разговор с ним психологически ближе к размышлению вслух, чем к диалогу с живым человеком. Из-за этого снижается уровень самоконтроля при формулировании ответов и выборе деталей.

Во-вторых, в коммуникации с ИИ отсутствует социальный контекст адресата. Это меняет критерии оценки сообщаемой информации и снижает внимание к её потенциальным последствиям.

В-третьих, формат помощи сам подталкивает к деталям. Чтобы получить точный ответ, пользователь добавляет контекст – сначала безобидный, затем всё более личный. Этот процесс постепенный, и момент, когда разговор выходит за границу осознанного, почти не замечается.

Поэтому речь идёт не об отдельных «опасных темах», а о самой модели взаимодействия с ИИ, в которой не учитываются реальные механизмы хранения, обработки и последствий использования данных.

Почему эта тема важна для родителей

ИИ-сервисы всё чаще используют дети и подростки – для учёбы, творчества, общения и поиска ответов на личные вопросы. При этом граница между обычным разговором и обработкой данных оказывается гораздо менее очевидной, чем кажется.

Исследователи Стэнфорда отмечают: по умолчанию пользовательские диалоги используются компаниями для обучения и доработки моделей. В ряде случаев такие данные хранятся долго, а иногда и без чётко обозначенного срока удаления. Часть компаний заявляет, что обезличивает информацию, но на практике не всегда понятно, где проходит граница между анонимными и вполне интерпретируемыми данными. Кроме того, в отдельных ситуациях переписку могут просматривать люди – например, для оценки качества работы ИИ.

В крупных экосистемах данные из чатов могут объединяться с информацией из других сервисов: поисковыми запросами, покупками, активностью в социальных сетях. В результате отдельные, на первый взгляд безобидные детали складываются в более целостное представление о пользователе.

Показательный пример: человек просит ИИ предложить идеи для ужина и уточняет, что ищет блюда с низким содержанием сахара или «полезные для сердца». Такой запрос может выглядеть бытовым, но из него уже можно сделать выводы о состоянии здоровья. Эти выводы не обязательно используются сразу – они могут постепенно влиять на рекомендации, рекламу и предложения услуг. Эффект здесь накапливается со временем.

Отдельного внимания заслуживает тема данных детей. Практики компаний в этом вопросе заметно различаются, но во многих случаях ввод, сделанный детьми, не исключается из сбора данных и обучения моделей. При этом дети не могут в полной мере осознанно соглашаться на использование своей информации, а значит, ответственность за её защиту ложится на взрослых и на сами платформы.

Именно поэтому ребёнку важно с раннего возраста объяснять простые и понятные вещи:

- переписка с ИИ может сохраняться;

- чат-бот не обязан хранить тайну разговора;

- даже обезличенные данные остаются реальными и значимыми.

Практический чек‑лист: как безопасно пользоваться ИИ‑чат‑ботами

Эти правила помогают выстроить понятные и устойчивые алгоритмы общения с ИИ.

Перед тем как писать

- Подумайте, допустимо ли, чтобы этот текст был сохранён или просмотрен в рамках работы сервиса.

- Проверьте настройки приватности и возможность отказа от использования данных для обучения моделей.

- Старайтесь формулировать вопросы обобщённо, не добавляя личных и легко узнаваемых деталей.

Не стоит писать в чат‑ботах

- Полные имена, адреса, номера телефонов.

- Пароли, PIN‑коды, данные банковских карт.

- Подробные медицинские истории и диагнозы.

- Конфиденциальную рабочую информацию и внутренние документы.

- Личные истории, которые могут навредить вам или ребёнку при утечке.

Можно обсуждать

- Общие учебные и познавательные вопросы.

- Абстрактные примеры и вымышленные ситуации.

- Технические задачи без персональных данных.

- Идеи, которые не привязаны к реальным людям и событиям.

Подробнее о цифровой гигиене мы писали ранее.

Итог

ИИ-чат-боты – удобный и полезный инструмент. Они помогают учиться, разбираться в сложных темах и находить идеи для работы и творчества. Но важно понимать: приватность в таких сервисах не возникает сама по себе и не гарантируется по умолчанию.

Простое правило цифровой гигиены здесь остаётся тем же, что и для любых онлайн-сервисов: не стоит рассказывать ИИ то, чем вы не готовы делиться за пределами личного разговора. Осознанное и спокойное отношение к технологиям позволяет пользоваться их возможностями и при этом снижать ненужные риски.

Если вам понравилась эта статья и хочется больше идей, советов и полезных материалов – подпишитесь на наш Telegram-канал! Там мы делимся эксклюзивным контентом, вдохновением и новостями.